# 바로 위에 개발한 머신러닝 모델은 길이가 25cm이고 무게가 150g이면 빙어모델로 예측한다고 함

fish_length = [25.4, 26.3, 26.5, 29.0, 29.0, 29.7, 29.7, 30.0, 30.0, 30.7, 31.0, 31.0,

31.5, 32.0, 32.0, 32.0, 33.0, 33.0, 33.5, 33.5, 34.0, 34.0, 34.5, 35.0,

35.0, 35.0, 35.0, 36.0, 36.0, 37.0, 38.5, 38.5, 39.5, 41.0, 41.0, 9.8,

10.5, 10.6, 11.0, 11.2, 11.3, 11.8, 11.8, 12.0, 12.2, 12.4, 13.0, 14.3, 15.0]

fish_weight = [242.0, 290.0, 340.0, 363.0, 430.0, 450.0, 500.0, 390.0, 450.0, 500.0, 475.0, 500.0,

500.0, 340.0, 600.0, 600.0, 700.0, 700.0, 610.0, 650.0, 575.0, 685.0, 620.0, 680.0,

700.0, 725.0, 720.0, 714.0, 850.0, 1000.0, 920.0, 955.0, 925.0, 975.0, 950.0, 6.7,

7.5, 7.0, 9.7, 9.8, 8.7, 10.0, 9.9, 9.8, 12.2, 13.4, 12.2, 19.7, 19.9]

import numpy as np

np.column_stack(([1, 2, 3], [4,5,6]))

fish_data = np.column_stack((fish_length, fish_weight))

print(fish_data[:5])

<출력>

[[ 25.4 242. ]

[ 26.3 290. ]

[ 26.5 340. ]

[ 29. 363. ]

[ 29. 430. ]]

# fish_target = [1] * 35 + [0] * 14 이 역할을 하던 놈

# np.ones(35) : 1이 35개인 배열, np.zeros(14) : 0이 14개인 배열

fish_target = np.concatenate((np.ones(35), np.zeros(14)))

# 앞에서는 훈련세트와 테스트 세트를 나눌때

# 번거롭게 랜덤 돌린 뒤 잘라냈지만

# 여기서는 train_test_spit()을 이용한다.

# 이는 섞는것까지 알아서 해줌

from sklearn.model_selection import train_test_split

train_input, test_input, train_target, test_target

= train_test_split(fish_data, fish_target, random_state=42)

# 비율이 안맞아 샘플링 편향이 나타난다고 볼 수도 있음

# 이를 해결하려면 stratify를 사용하면된다.

print(test_target)

train_input, test_input, train_target, test_target

= train_test_split(fish_data, fish_target, stratify=fish_target, random_state=42)

print(test_target)<출력>

[1. 0. 0. 0. 1. 1. 1. 1. 1. 1. 1. 1. 1.]

[0. 0. 1. 0. 1. 0. 1. 1. 1. 1. 1. 1. 1.]

from sklearn.neighbors import KNeighborsClassifier

kn = KNeighborsClassifier()

kn.fit(train_input, train_target)

kn.score(test_input, test_target)

# 바로 위에 개발한 머신러닝 모델은 길이가 25cm이고 무게가 150g이면 빙어모델로 예측한다고 함... 고쳐졌으려나?

print(kn.predict([[25, 150]]))<출력>

[0.]

# 삐빅... 빙어 입니다!

# 도미? 놉! 어찌 된일 일까요?

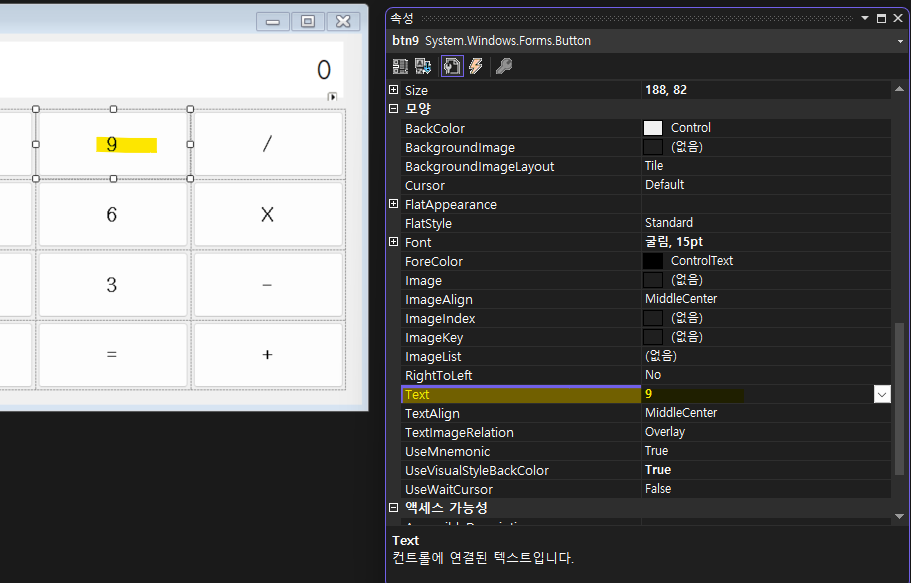

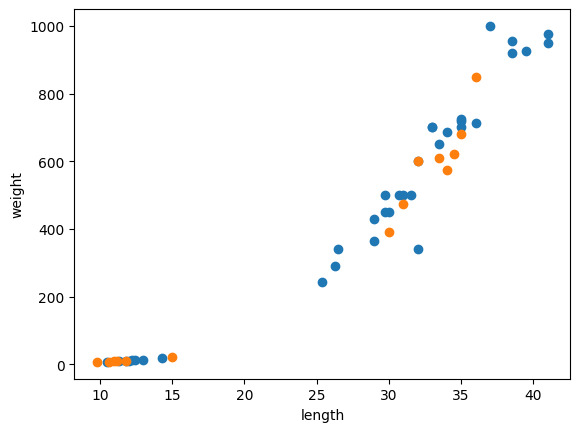

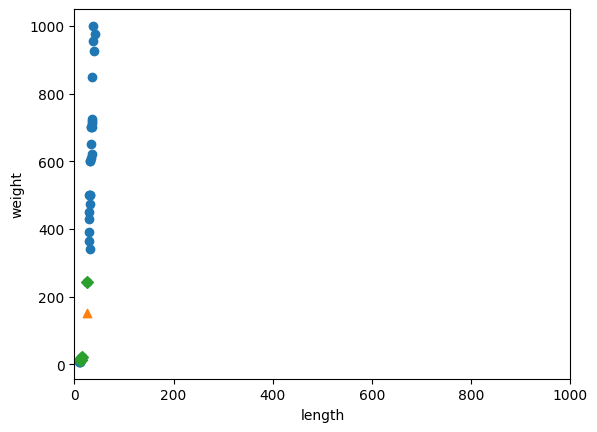

import matplotlib.pyplot as plt

plt.scatter(train_input[:,0], train_input[:,1])

plt.scatter(25, 150, marker='^') # marker는 특정 값의 매개변수의 모양을 지정 ^ 는 삼각형 모양으로 표시시

plt.xlabel('length')

plt.ylabel('weight')

plt.show()

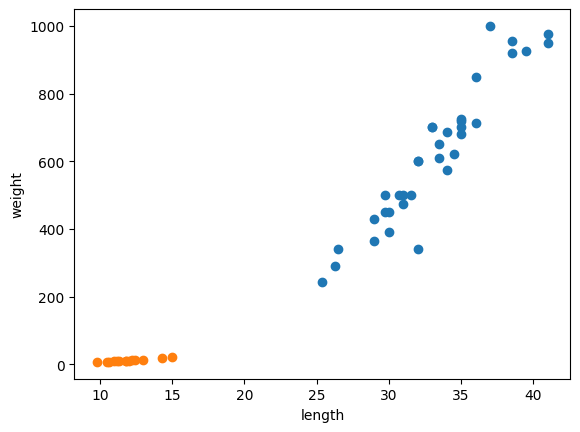

# 위 데이터 상에서는 도미 데이터에 가까운데 왜 빙어라고 평가 할까?

distances, indexes = kn.kneighbors([[25, 150]])

plt.scatter(train_input[:,0], train_input[:,1])

plt.scatter(25, 150, marker='^')

plt.scatter(train_input[indexes,0], train_input[indexes,1], marker='D') # marder D는 마름모 모양

plt.xlabel('length')

plt.ylabel('weight')

plt.show()

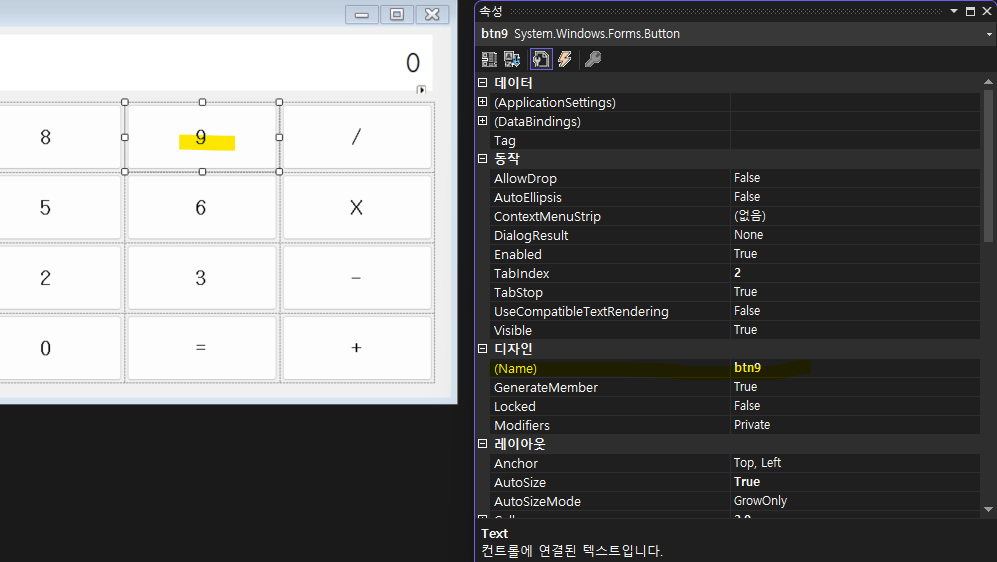

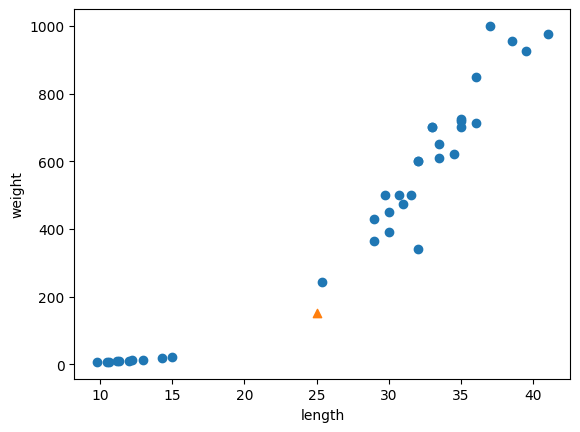

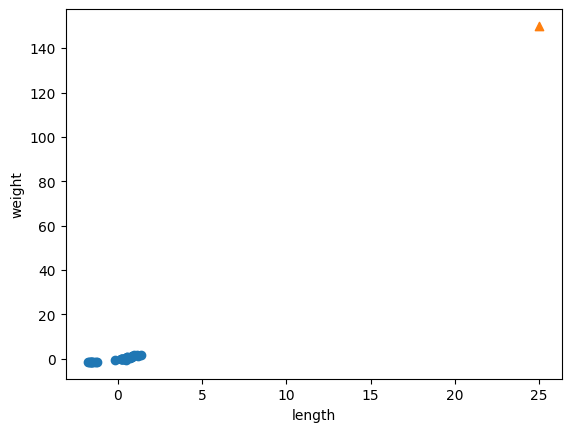

# 그래프 y축 한칸의 크기가 너무 커서 그렇지 실제로는

plt.scatter(train_input[:,0], train_input[:,1])

plt.scatter(25, 150, marker='^')

plt.scatter(train_input[indexes,0], train_input[indexes,1], marker='D')

plt.xlim((0,1000))

plt.xlabel('length')

plt.ylabel('weight')

plt.show()

# 그래프와 같이 현재 데이터에서는 x값은 사실 생선을 판단하는데 큰 영향이 없다고 볼 수 있음

# (y축에 비해 너무 미미하여 영향력이 거의 없다고 받아들여짐

# 범위가 다르기 때문(스케일이 다르다)

# 다른 단위로 이루어진 샘플간에 특성값을 일정한 기준으로 맞추는 것을 데이터 전처리 라고 한다.

# 교재에서는 널리 사용하는 전처리 방법 중 하나가 표준점수라고하고

# 값에서 평균을 뺴고 표준편차로 나누어주면된다고 한다.

# 통계학에서는 정규화 라고 하는데 크기에 상관없이 기준을 맞추는 작업으로 볼 수 있을 것같다

mean = np.mean(train_input, axis=0)

std = np.std(train_input, axis=0)

print(mean, std)

train_scaled = (train_input - mean) / std

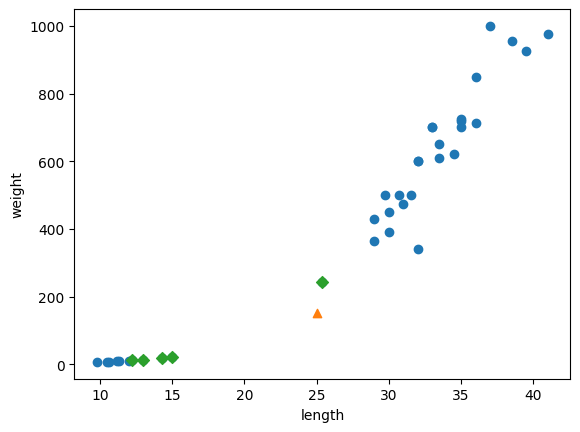

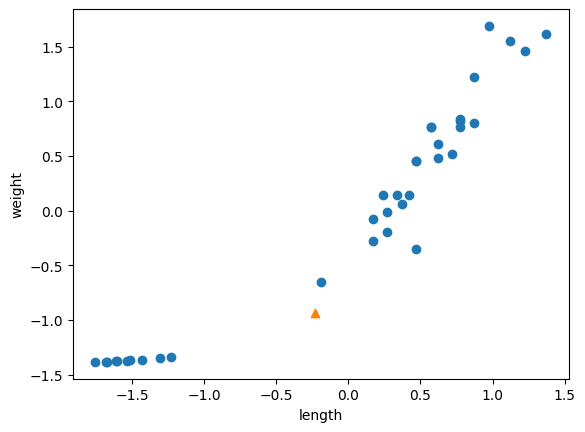

# train_scaled 로 산점도를 다시 그려본다.

plt.scatter(train_scaled[:,0], train_scaled[:,1])

plt.scatter(25, 150, marker='^')

plt.xlabel('length')

plt.ylabel('weight')

plt.show()

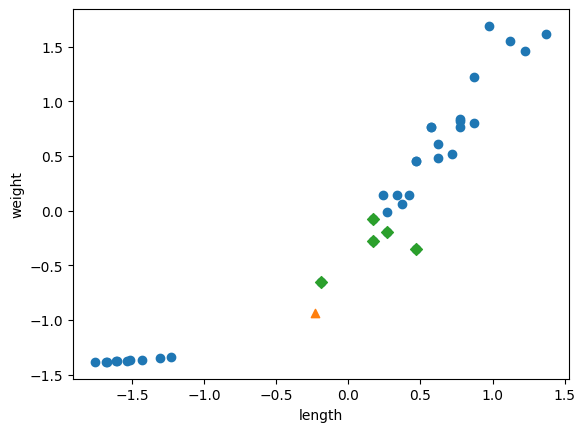

# 새로 넣을 데이터도 표준화 해야한다.

new = ([25, 150] - mean) / std

plt.scatter(train_scaled[:,0], train_scaled[:,1])

plt.scatter(new[0], new[1], marker='^')

plt.xlabel('length')

plt.ylabel('weight')

plt.show()

kn.fit(train_scaled, train_target)

test_scaled = (test_input - mean) / std

kn.score(test_scaled, test_target)

print(kn.predict([new]))<출력>

[1.]

distances, indexes = kn.kneighbors([new])

plt.scatter(train_scaled[:,0], train_scaled[:,1])

plt.scatter(new[0], new[1], marker='^')

plt.scatter(train_scaled[indexes,0], train_scaled[indexes,1], marker='D') # marder D는 마름모 모양

plt.xlabel('length')

plt.ylabel('weight')

plt.show()

'language & Framework > python' 카테고리의 다른 글

| [머신러닝] 02-1 훈련세트와 테스트 세트 (0) | 2023.04.16 |

|---|---|

| [머신러닝] 01-1~01-3 KNeghborsClassifier 객체 (0) | 2023.04.13 |

| python - 머신러닝 기초 공부 (0) | 2023.04.11 |